-

Compteur de contenus

6 075 -

Inscription

-

Dernière visite

-

Jours gagnés

22

Tout ce qui a été posté par Anton_K

-

Méta l'hurlant (mais aussi plus calme)

Anton_K a répondu à un sujet de Hidalgo dans Sports et loisirs

Pas d'erreur de ta part, le batteur est un camarade de lycée avec qui j'ai joué dans mon tout premier groupe hehe. J'ai pas encore entendu ce nouvel album mais ça ne va pas tarder. -

Méta l'hurlant (mais aussi plus calme)

Anton_K a répondu à un sujet de Hidalgo dans Sports et loisirs

-

Emmanuel Todd, brillant ou escroc ?

Anton_K a répondu à un sujet de Pegase dans Philosophie, éthique et histoire

C'est fondé sur les différences traditionnelles de répartition des héritages et responsabilités entre les enfants d'une famille, et c'est sensé prédire une variété de préférences et comportements sociaux et en particulier les choix électoraux. Via ce que ça commande comme intuition quant à quel type de partage est juste, j'imagine. -

Je conseille notamment "Kill the Artist" Et ici, Vexilla Regis Inferni et Trinity @Ultimex@F. mas@fryer@Sekonda Le yelworC est un chef d'oeuvre à mon avis, l'autre c'est plus pour la trouvaille.

-

non mais on est où là? ... les bases se perdent.

-

🤔

-

C'est drôle que tu dises ça parce que c'est comme si tu n'avais pas vu les épisodes dont tu parles. Qui ça "vous"?

-

ce ne sont pas les auteurs qui font la promo. Encore une fois prenez deux heures, regardez le truc, ça vous donnera le sens des proportions.

-

Je suis pas en train de vous dire que c'est bien qu'ils l'aient fait, que ces pressions de son pas anti-artistiques et que hollywood n'est pas woke. Mais cette série n'est pas woke au sens où elle n'a pas un propos woke. Elle a des défauts mais pour l'instant son défaut n'est pas d'être woke. Si vous dites qu'elle est woke, donnez moi le sous-texte militant. De la même manière l'Éternel Retour de Delannoy et Cocteau n'est pas un film collaborationiste ou nazi même s'il cocha en son temps quelques cases. L'article cité dans contrepoint est ridicule et montre bien comment en anticipant trop les conneries woke on surjoue la guerre culturelle.

-

Je suis quand même curieux qu'on m'explique en quoi, au vu des deux premiers épisodes, cette série est woke. Il est quasiment évident que la présentation des minorités y est une pure formalité et à mon avis une case cochée, assez minimalement, pour éviter des débats relous. Si vous voyez un sous-texte de politique identitaire, expliquez le moi.

-

Sinon il n'y a que moi qui voit un parallèle intéressant entre l'occupation US de l'Iraq et de l'Afghanistan la traque de Ben Laden telle que montrée dans Zero Dark Thirty et ce qu'on voit dans ce début de série avec Galadriel en Jessica Chastain et Sauron en OBL ? C'est tout le contenu politique que j'ai réussi à y trouver pour l'instant.

-

Enfin quelqu'un qui a regardé. Je comprends qu'on s'arrête sur les détails comme le combat contre le troll, mais par contre refaire maintenant le débat sur la race des acteurs... faut passer à autre chose. C'est tout aussi discutable qu'il y a deux ans quand le truc a été annoncé, et en plus c'est quand même assez modéré. Dire que c'est woke est totalement exagéré, pour l'instant c'est même carrément une formalité. Pour l'instant il n'y a absolument aucune politisation dans l'écriture. Des trucs que j'ai bien aimé : les hobbits primitifs pas encore établis, avec leurs styles dyonisiaques franchement bonne idée. La scène dans le bateau avec les elfes qui se tiennent tous droits comme des imagesbouquins mormons c'est excellent, et justement ça ressemble à de l'illustration romantique tardive/victorienne un peu kitsch. Galadriel qui repart en terre du milieu à la nage c'est assez authentiquement mythologique comme idée absurde, non? L'introduction de Gandalf même si c'est un peu long et que certains dialogues sonnent un peu artificiels (de toute façon on a compris que le rythme allait être aux fraises) c'est quand même pas mal stylé, non?

-

Le fil des séries (dont beaucoup trop se bousémotivent)

Anton_K a répondu à un sujet de Brock dans Sports et loisirs

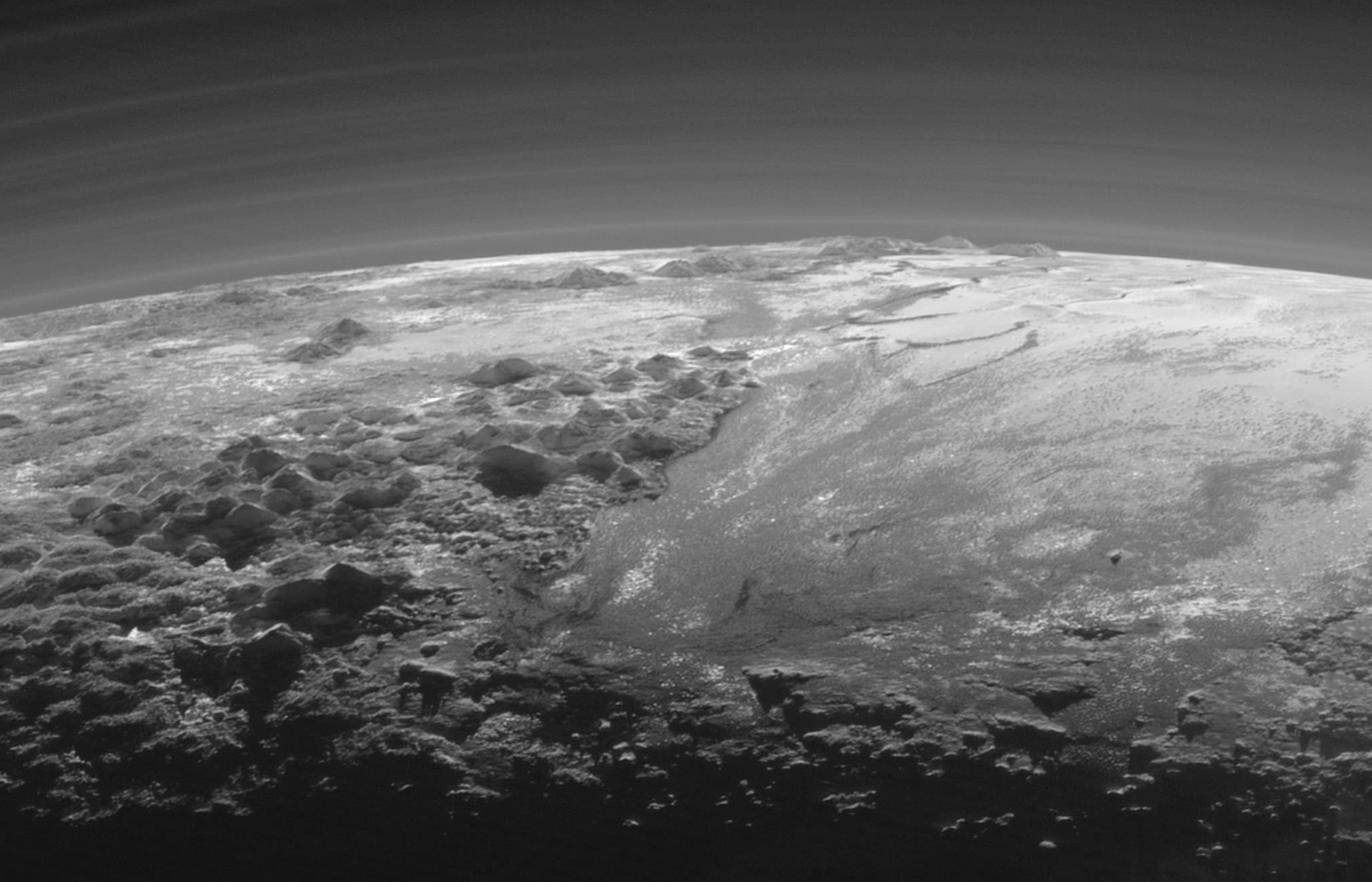

c'est quand même assez joli et dans le ton... dommage que ce soit aussi pas mal chiantosse. -

Méta l'hurlant (mais aussi plus calme)

Anton_K a répondu à un sujet de Hidalgo dans Sports et loisirs

J'y suis allé vendredi (j'ai vu Fauxx, Dead Heat, Youth Code, Health, Nitzer EBB, Killing Joke, Ministry, Alice Cooper et NIN de près, et une partie de Kreator et Megadeth de loin. TW @fryer, @Ultimex j'ai raté Godflesh 😬). Tout était bien, ma seule déception légère étant Killing Joke, le seul groupe à ne pas sonner très bien, et avec un set que j'ai trouvé pas des plus excitants même si le début et la fin étaient bien. NIN étaient vraiment incroyables, une apparition dans la fumée, un show au cordeau avec un son d'une clarté inouïe. Mes visites précédentes étaient en 2011 et 2013. Depuis, l'organisation s'est énormément améliorée. Des sanitaires partout, plutôt propres (le fait que le site devienne permanent a surement aidé), énormément de stands de nourriture et de boisson (on fait toujours le queue mais moins longtemps), des zones mainstage pavées, donc pas de boue. Certes une impression de foule encore plus oppressante que les fois précédentes, mais d'un autre côté je suis toujours arrivé à me faufiler aussi près de la scène que je voulais, même sans faire de sit in avant (même si j'en ai fait un pour NIN quand même...). Pour le camping je ne peux pas dire, évidemment. Bon, il a plu toute la journée, on est rentrés trempés la nuit avec trois trains différents et de looongues correspondances, c'était pas une partie de plaisir. Mais à part sur ce dernier point je garderai un excellent souvenir. -

ah, tiens donc? 😏

-

Méta l'hurlant (mais aussi plus calme)

Anton_K a répondu à un sujet de Hidalgo dans Sports et loisirs

D'ailleurs juste pour info, ce soir y'a Mayhem + Mortiis à Paris et c'est pas sold out. -

Méta l'hurlant (mais aussi plus calme)

Anton_K a répondu à un sujet de Hidalgo dans Sports et loisirs

La set list de mgła le 24 mai. https://music.youtube.com/watch?v=ZQ9yrGl1OmA&list=PLZuBM6BbL73lhoD8ZOG8GeZJd6coNXfOd @fryer toujours d'attaque ? @Ultimex @Vilfredo ça pourrait être sympa de s'y retrouver (si vous aimez le groupe) -

Tu vas pas tarder à tomber dans la body music avec de tels crushes! Par ailleurs je connaissais pas du tout ce morceau.

-

J'écoute Spectre du coup, j'avais pas trop aimé initialement, et c'est vrai que No History est pas mal. Eh tiens, maintenant j'entends Eat Liver comme une sorte de cover de Kas Product.

-

La mollesse de la performance et du mix cependant...

-

Ah, j'avais l'impression qu'il divisait pas mal. A tout le moins sommes nous du même côté. Puisque nous en sommes à sonder la sensibilité du newbie @Vilfredo, que penses-tu de ça ?: On parlait hier soir eu courant païen dans le black metal, cet album en est une des références principales. Ils étaient tellement chauvins qu'ils ont nommé ce style (qui a fait école) du nom de leur Fjord, c'est donc du Sognametal. Un peu kitsch mais très bien écrit, franchement beau même. Le compositeur avait vingt ans et était promis à mourir cinq ans plus tard dans une tempête de neige.

-

J'aime bien cette version aussi, leur orchestration me rappelle un peu l'album Volk, que j'avoue bien aimer. Mais sans Mina Harker en effet le chant ne tiendrait pas la distance.

-

@Vilfredo et celle là du l'as entendue? Sinon dans les Revisited, sans surprise c'est quand même surtout Brat Moj, Ti ki izivas et Smrt za smrt qui valent le coup.

-

Je viens juste de voir qu'en 2020 ils avaient sorti un album de versions revisitées (qui s'appelle "Revisited") de leurs premiers morceaux, qui ressemblent donc pas mal aux versions qu'ils jouent en concert depuis pas mal d'années.